La irrupción de la inteligencia artificial ha convertido a Nvidia en la tercera compañía más valiosa en bolsa del mundo, sólo por detrás de Microsoft y Apple. En el transcurso del último año ha multiplicado por tres su capitalización bursátil y ha superado en los parqués a gigantes como Google o Amazon.

Detrás de esta explosión en popularidad se encuentra su GPU para inteligencia artificial Hopper H100. El rendimiento que brinda es muy superior al de cualquier otro producto de la competencia y las grandes tecnológicas la están comprando en enormes cantidades a pesar de su elevadísimo precio.

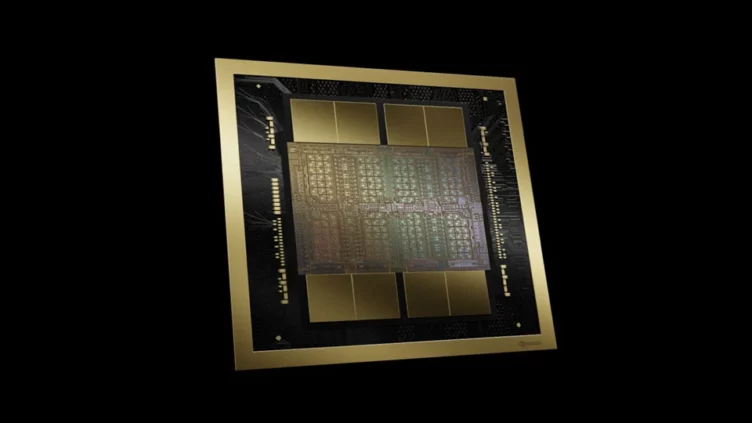

Hoy, Jensen Huang, CEO de Nvidia, ha presentado a su sucesora. Se llama Blackwell B200, contiene 208.000 millones de transistores y ofrece una capacidad de cálculo de hasta 20 petaFLOPS. El «superchip» GB200, que contiene dos de esas GPUs y una CPU Grace, multiplica por 30 las prestaciones posibles con la generación anterior en modelos de lenguaje de gran tamaño al tiempo que consume hasta 25 veces menos.

A modo de ejemplo, el ejecutivo taiwanés ha explicado que entrenar un modelo de lenguaje de 1,8 billones de parámetros habría precisado de 8.000 GPUs Hopper H100 y una potencia de 15 MW. En cambio, señala, se necesitan sólo 2.000 Blackwell B200 para realizar la misma tarea, lo que reduce el consumo hasta unos, en comparación, más modestos 4 MW.

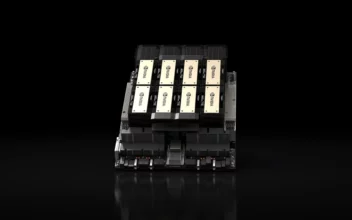

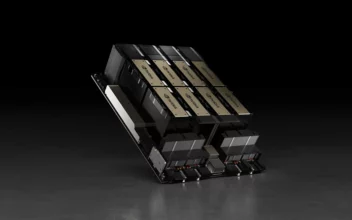

Nvidia va a ofrecer a las grandes compañías interesadas en esta tecnología racks como el GB200 NVL72 equipados con 36 CPUs y 72 GPUs que van a ofrecer un rendimiento de 720 petaFLOPS. Estas instalaciones van a incluir refrigeración líquida y en su interior van a contar con unos 5.000 cables individuales y más de 3 kilómetros de cables en total.

La compañía ha anunciado que Amazon, Microsoft, Google y Oracle, entre otros, han encargado un gran número de estos racks y los van a alquilar a través de sus servicios de computación en la nube a aquellos clientes que los necesiten. El precio de estos servicios, no hace falta decirlo, no va a ser barato.

El roguelike Dark Light: Survivor, anunciado para PC

El roguelike Dark Light: Survivor, anunciado para PC Hunt: Showdown 1896 llega el 15 de agosto a la PS5, Xbox Series y PC

Hunt: Showdown 1896 llega el 15 de agosto a la PS5, Xbox Series y PC El estreno de S.T.A.L.K.E.R. 2: Heart of Chornobyl se pospone hasta noviembre

El estreno de S.T.A.L.K.E.R. 2: Heart of Chornobyl se pospone hasta noviembre La versión web de Apple Maps, disponible desde hoy en beta

La versión web de Apple Maps, disponible desde hoy en beta