Microsoft ha desvelado esta tarde el primer chip que ha creado específicamente para aplicaciones relacionadas con la inteligencia artificial. Denominado Maia 100, comenzará a instalarse en sus centros de procesamiento de datos a principios del año que viene.

Microsoft ha señalado que, una vez se complete su integración, los clientes de su servicio de computación en la nube Azure tendrán a su disposición una mayor capacidad de cálculo para manejar las enormes cantidades de información que requieren los programas de inteligencia artificial generativa.

Rani Borkar, vicepresidenta de la división de Azure en Microsoft, ha explicado que están testeando este chip en las soluciones de IA que forman parte de Bing y Office. También está teniendo acceso preferencial al mismo OpenAI, la empresa que está detrás de ChatGPT y de la que Microsoft es uno de sus accionistas mayoritarios.

El desarrollo de Maia 100 tiene un doble objetivo. Por una parte, potenciar el rendimiento de sus servidores y hacerlos más competitivos en un campo como el de la inteligencia artificial que está creciendo a una velocidad de vértigo.

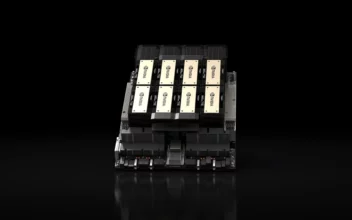

Pero además, Microsoft quiere disminuir su dependencia de Nvidia, que domina a placer este sector con su gama de tarjetas gráficas profesionales, que comercializa a precios elevadísimos y que, dependiendo del modelo, superan sobradamente las decenas de miles de euros.

De hecho, Nvidia presentó ayer mismo su nueva tarjeta gráfica HGX H200, que asegura que ofrece casi el doble de velocidad de prestaciones respecto a la H100 en modelos de lenguaje de gran tamaño que hacen uso de decenas de millones de parámetros.

Microsoft ha querido dejar claro que, además de su chip, seguirá ofreciendo centros de procesamiento de datos que hagan uso de las tarjetas Nvidia HGX H200 o AMD MI300X a aquellos clientes que así lo deseen.

Una puntualización necesaria debido precisamente a la omnipresencia de las soluciones creadas por Nvidia pero que confía que dejará de ser imprescindible en unos años si chips como Maia 100 tienen la acogida que espera.

El roguelike Dark Light: Survivor, anunciado para PC

El roguelike Dark Light: Survivor, anunciado para PC Hunt: Showdown 1896 llega el 15 de agosto a la PS5, Xbox Series y PC

Hunt: Showdown 1896 llega el 15 de agosto a la PS5, Xbox Series y PC El estreno de S.T.A.L.K.E.R. 2: Heart of Chornobyl se pospone hasta noviembre

El estreno de S.T.A.L.K.E.R. 2: Heart of Chornobyl se pospone hasta noviembre La versión web de Apple Maps, disponible desde hoy en beta

La versión web de Apple Maps, disponible desde hoy en beta