Esta semana se cumplen seis meses desde el lanzamiento de ChatGPT, un chatbot basado en la inteligencia artificial que ha revolucionado la manera en que interaccionamos con las nuevas tecnologías, buscamos contenidos y obtenemos respuestas a todo tipo de dudas que podamos tener.

Su explosión en popularidad ha convertido a OpenAI, la startup que lo creó, en un nombre familiar para millones de personas en todo el mundo. Microsoft, que tantas otras veces había reaccionado tarde a la aparición de tecnologías rompedoras, en esta ocasión atisbó antes que nadie el potencial de la inteligencia artificial y, primero en 2019, y nuevamente a principios de este año, invirtió miles de millones en esta empresa, entró en su accionariado y se aseguró una opción preferencial para integrar el modelo de lenguaje GPT-4 que había desarrollado en servicios como Bing, Microsoft 365, GitHub o Edge.

La otra gran beneficiada de la llegada de la inteligencia artificial, y probablemente de la que menos se habla, está siendo Nvidia. De noviembre hasta ahora, su capitalización bursátil se ha prácticamente doblado, hasta el punto de que hoy en día vale casi tres veces más en bolsa que Intel y AMD… combinadas. Concretamente, Nvidia está valorada en estos momentos en 670.000 millones de dólares, mientras que Intel lo está en 126.000 millones y AMD en 142.000 millones.

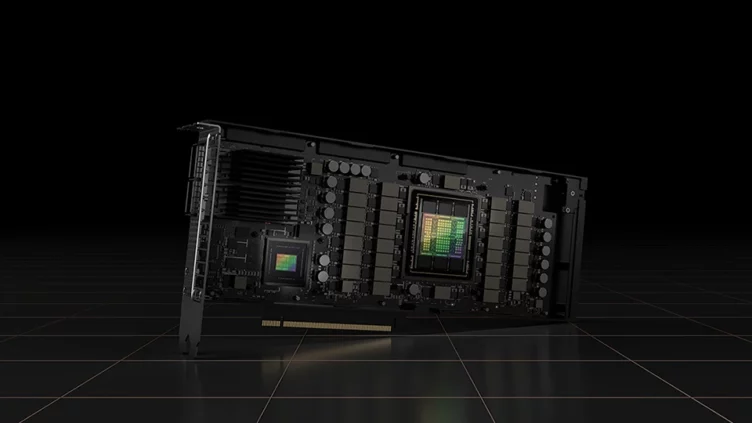

La explicación a esta subida tan repentina se debe a que las tarjetas gráficas de las series H100 y A100 se han convertido en el estándar de facto de la industria para entrenar a los modelos de lenguaje de gran tamaño que utilizan los programas de inteligencia artificial para efectuar sus cálculos.

Cualquier empresa que quiera desarrollar un modelo de lenguaje propio necesita decenas de miles de tarjetas gráficas, y Nvidia las vende por cantidades elevadísimas. El precio de las H100 va desde los 30.000 a los 40.000 euros, mientras que las más «económicas» A100 se pueden conseguir por cifras en torno a los 10.000 euros.

Microsoft, Google, Facebook, Amazon, Adobe, probablemente Apple, y multitud de otras compañías tecnológicas menos conocidas, están compitiendo para crear los modelos de lenguaje más avanzados con los que surtir de información a sus plataformas de inteligencia artificial, pero todas ellas, de la primera a la última, son clientes de Nvidia y necesitan de la capacidad de computación de sus tarjetas gráficas profesionales.

Los costes de sus soluciones son tan altos, que muchas de ellas están desarrollando hardware para reducir su dependencia de Nvidia. Es el caso, por ejemplo, de Microsoft, que ha comenzado a distribuir entre miembros de su departamento de inteligencia artificial los primeros prototipos de un chip creado específicamente para este tipo de tareas.

De acuerdo a la información que se ha filtrado, la intención de Microsoft no es que sustituya por completo a las tarjetas de Nvidia, sino que las complemente y haga que no necesiten comprar tantas para entrenar a sus sistemas. Se sabe que, al menos, Facebook, Google y Amazon están trabajando en soluciones similares, pero no se ha dado a conocer el punto de desarrollo en el que se encuentran sus chips ni el rendimiento que esperan obtener de los mismos.

El roguelike Dark Light: Survivor, anunciado para PC

El roguelike Dark Light: Survivor, anunciado para PC Hunt: Showdown 1896 llega el 15 de agosto a la PS5, Xbox Series y PC

Hunt: Showdown 1896 llega el 15 de agosto a la PS5, Xbox Series y PC El estreno de S.T.A.L.K.E.R. 2: Heart of Chornobyl se pospone hasta noviembre

El estreno de S.T.A.L.K.E.R. 2: Heart of Chornobyl se pospone hasta noviembre La versión web de Apple Maps, disponible desde hoy en beta

La versión web de Apple Maps, disponible desde hoy en beta